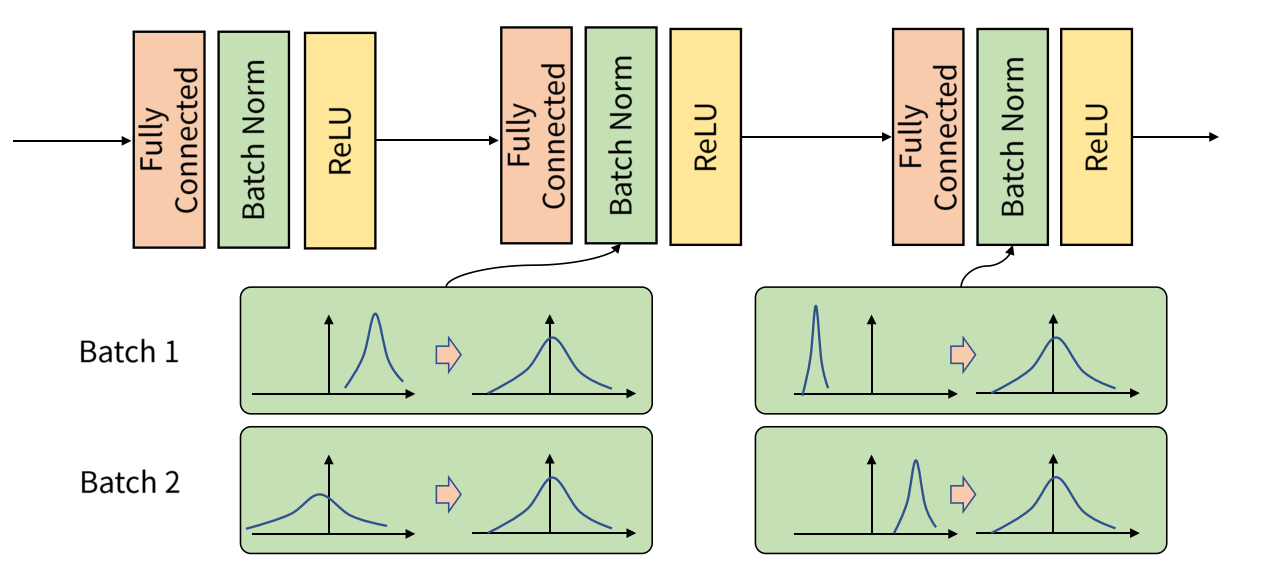

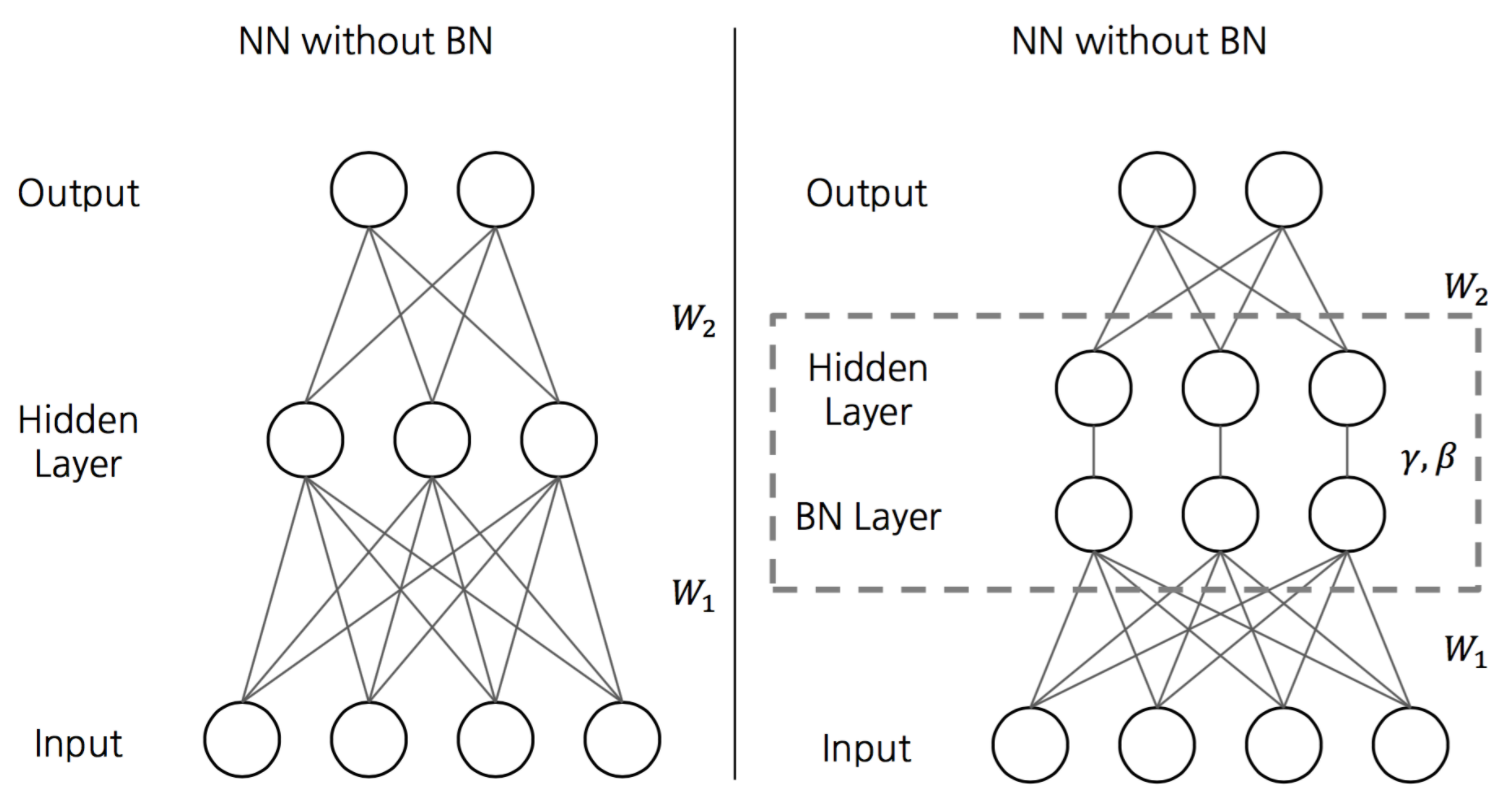

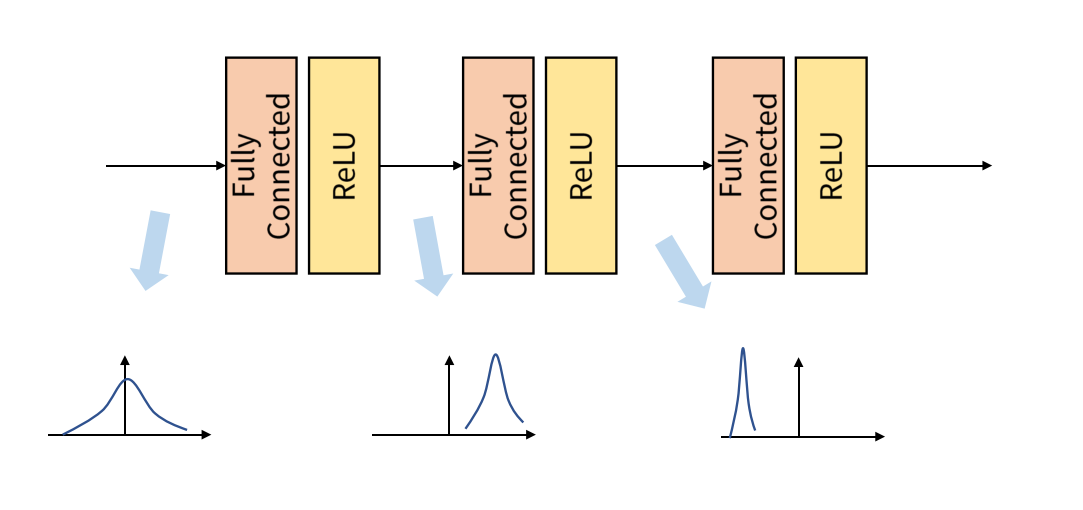

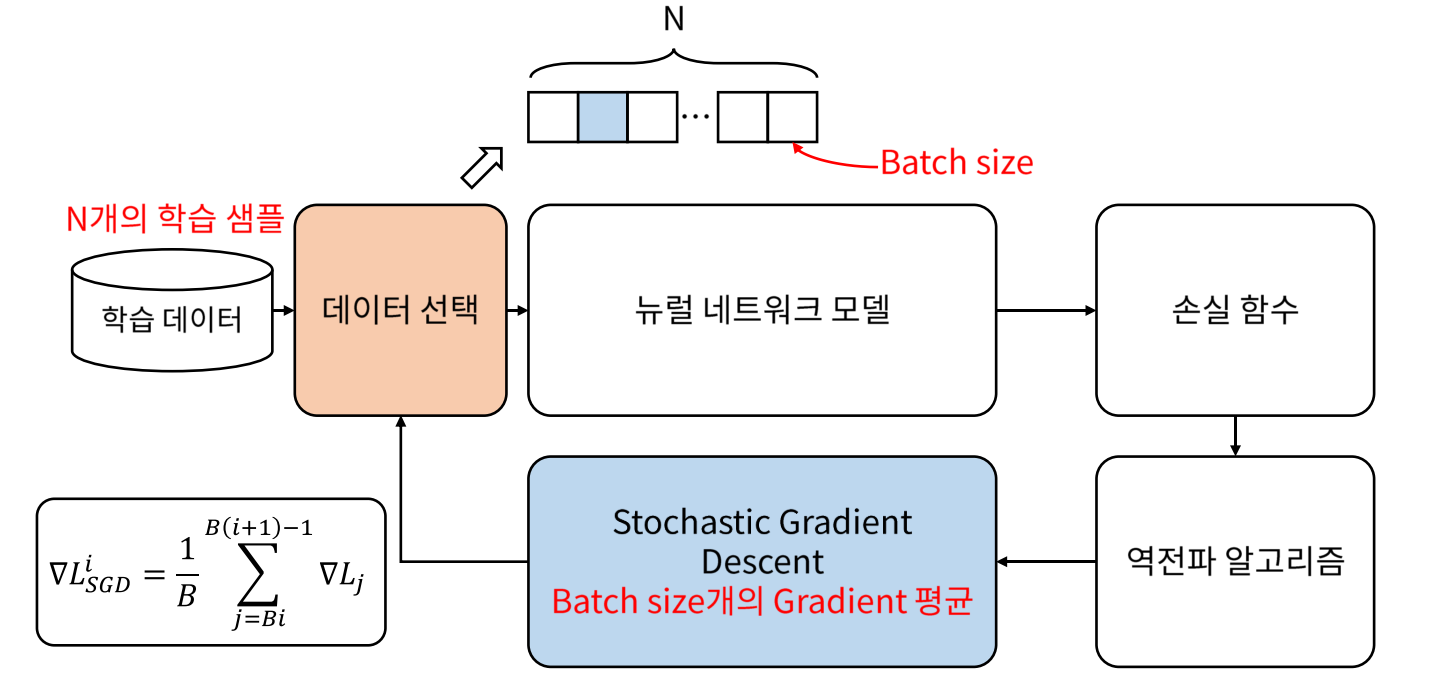

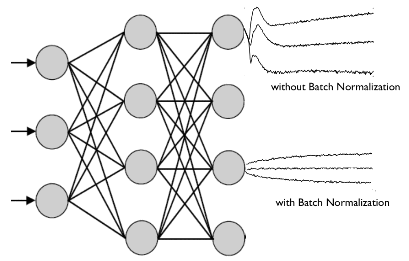

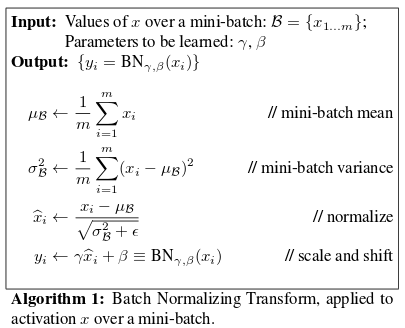

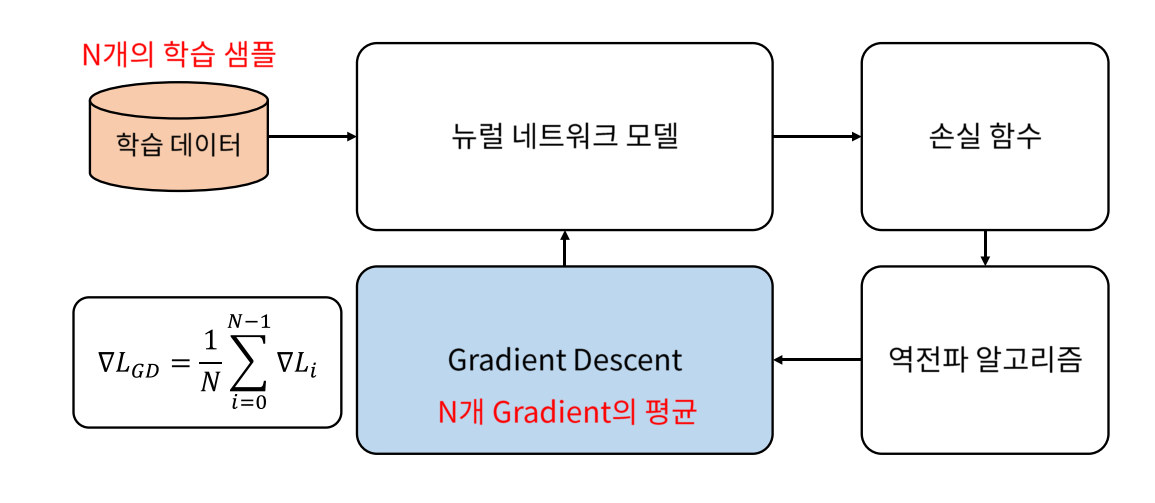

Overfitting방지 기법의 하나인 Training시 입력되는 배치의 분포가 매번 바뀌면, 각 레이어의 output분포가 바뀌–>분포가 크게 바뀌면, Internal Covariate Shift라는 문제 1:레이어의 output분포가 매번 바뀌면서 모델은 학습 방향을 정하지 못한 문제 2:뒤의 레이어의 경우 분포의 차이가 커질 가능성이 있다. 기존의 해결 방법 Careful initialization, but difficult Small learning rate, but slow배치 정규화(Batch n내외 분포의 변화가 크지 않으면 학습이 잘 되리라는 가정 Weight적용 후, 분포 변화를 줄일 목적->Activation function의 inputrange을 제한하는 Weighted sum의 스케일을 줄인다(–>normalization느낌)–>기존 분포와 크게 다르지 않은 Activation의 non-linear를 적절히 반영하기 때문에 스케일된 weighted sum의 분포를 shift함장 점 Fastlearning Less careful initialization Regularization(불필요)

![[콜레트] 20세기 시대를 만들어간 여성 작가이자 사업가. 굴레를 벗고 자유를 찾는 과정을 담아내다 [콜레트] 20세기 시대를 만들어간 여성 작가이자 사업가. 굴레를 벗고 자유를 찾는 과정을 담아내다](https://www.womennews.co.kr/news/photo/202012/204928_332151_3148.jpg)